本方案旨在通过ChatGpt等LLM大语言模型,对企业积累的专业知识库内容进行向量搜索分析,实现高效的内容索引与检索,并提供流畅的知识库问答体验。

一、产品主要优势

1、高效的内容处理与存储:与传统知识库工具相比,我们的方案通过问答形式处理和存储内容,这不仅减少了向量化内容的长度,而且更清晰地界定了文本的含义。这种方法显著提高了搜索精度,使得用户能够更快地找到所需信息。

2、专业知识库的引入:我们的系统支持引入专业知识库,避免了来自未经验证的、非权威性内容对知识库的污染,确保了提供的解答的准确性和可靠性。此外,每条信息后都附有来源和链接,便于用户扩展学习和深入研究。

3、富有吸引力的交互体验:通过模拟聊天对话的方式,用户的查询过程变得更为生动有趣。我们的大语言模型AI框架不仅支持日常信息的查询,也能引导员工高效地补充和更新他们的专业知识。

4、灵活的知识库维护:知识库的维护支持多种数据格式,包括文本、文档等。在基础框架搭建完成后,后续的内容更新和维护可以通过自动化数据处理程序轻松实现,大大降低了人工维护的需要。

5、定制化的扩展功能:通过内置的工作流引擎,我们的系统支持将动态数据集成到服务框架中。根据企业的具体需求,可以实现数据汇总、内容存储和基于文件模板的扩展功能等。这些功能可以完美嵌入问答聊天环境,为企业提供个性化的解决方案。

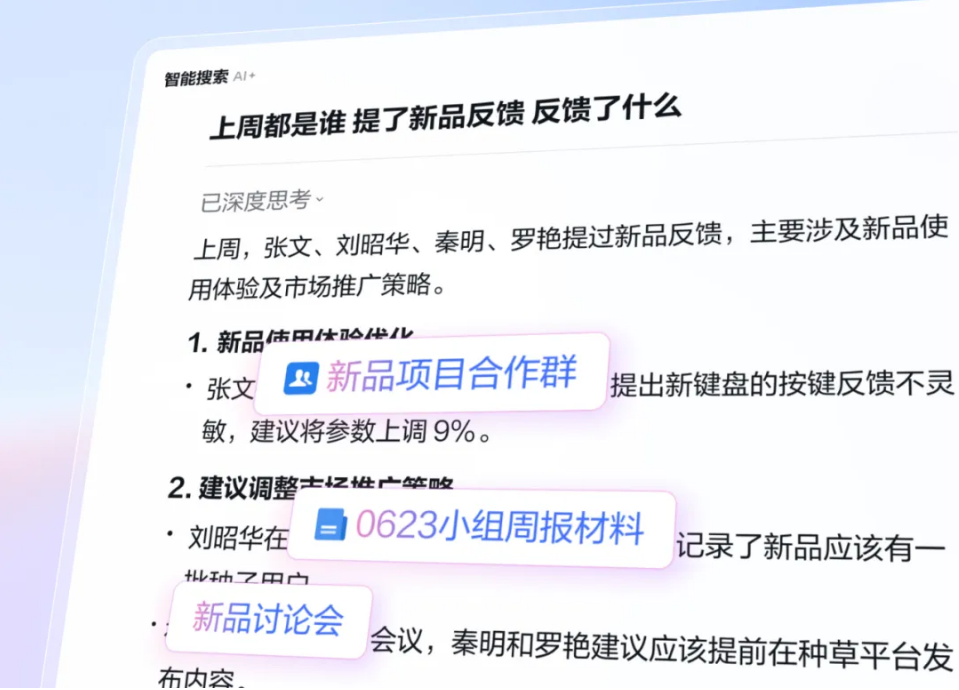

二、技术框架简介

AI知识库总体技术框架图

核心技术栈包括四个主要部分:

1、LLM大语言模型:根据企业的具体需求,可选择部署ChatGPT或ChatGLM。两者的具体技术差异和适用场景将在部署方案部分进行详细说明,以帮助企业做出最适合其业务需求的选择。

2、内容向量分析引擎:此引擎支持对知识库中的内容进行向量化分析和索引。通过这种方式,我们能够提供高效的内容检索支持,确保信息检索的速度和准确性。

3、对话向量搜索引擎:利用先进的匹配算法,此引擎能将用户的问题与知识库中的内容进行精准拟合分析。这不仅增强了对用户查询的理解,还能提供高精度的答复,显著提升用户满意度。

4、工作流配置引擎:集成了强大的Flow工作流引擎,允许人工对问答流程进行细致优化。这一特性支持企业根据实际使用情况调整和优化问答效率,实现流程的持续改进。

三、知识库部署方案

根据客户对数据安全性的要求,以及在建设与使用成本间的取舍,我们提供了三种知识库部署方案,其主要差异如下:

| AI知识库 | ChatGpt版本 | ChatGlm2云端版本 | ChatGlm2私有化部署 |

| 建设成本 | 较低 | 较低 | 较高 |

| 使用成本 | 较高 | 较低 | 仅需运维成本 |

| 硬件要求 | 4C8G服务器一台 | 4C8G服务器一台 | 8C32G服务器一台 4090以上AI显卡 |

| 注:可使用云服务器或本地服务器 | 注:可使用云服务器或本地服务器 | 注:只可使用本地服务器 | |

| 优势 | 语义识别能力强,基础信息库内容丰富 | 使用成本较低,通讯数据不会传输到境外服务器 | 数据只在内网传输和存储,知识库和通讯内容无外泄风险,使用成本低 |

| 劣势 | 使用成本略高,通讯数据可能传输到境外服务器 | 语义识别精度和基础信息库内容较 ChaGpt 版本稍有不足 | 基础建设成本及硬件成本较高,需要独立显卡保证大模型运行 |

| 适合 | 对内容精度要求高,对数据安全性要求较低的场景 | 对成本比较敏感,对数据安全性要求一般的场景 | 希望降低长期使用成本,对数据安全性要求高的场景 |

四、建设与实施步骤

需求沟通与确认 约3-5个工作日

对产品需求细节进行沟通,形成需求文档定稿,开发团队同步推进技术方案细节调整。同时会向企业明确知识库初始化内容需求,由企业进行知识库准备。

产品调整与部署 约10个工作日

开发团队根据需求对产品进行调整和部署,并在测试服务器完成产品服务框架建设。如产品需要引入企业微信/钉钉/OA等第三方平台,需提前准备好相关账户信息及调试环境。

知识库内容初始化 约1-5个工作日 根据内容量而定

将企业提供的知识库内容作为初始内容框架引入系统,并根据企业需求对服务流程进行调整优化。

产品测试与验收

由企业验收团队对产品进行完整测试,满足验收条件后提交验收报告完成验收。

产品交付与培训

运维团队将产品迁移至生产环境,完成产品交付。产品交付后,我们会对企业相关操作人员提供一次远程培训服务,解决产品使用中的问题。

产品维保

产品交付后进入维保阶段,运维团队将提供在线运维支持服务,小故障2小时内恢复,大故障6小时内提供解决方案。在运维阶段,除保障服务正常进行外,还将持续提供相应的AI框架版本升级服务(小版本升级免费,大版本升级视情况而定)。

版权声明

本文仅代表作者观点,不代表本站立场。

本文系作者授权发表,未经许可,不得转载。

评论